Digitale Bilder mit KI, GAN und OpenAI GPT3 und DALL·E 2

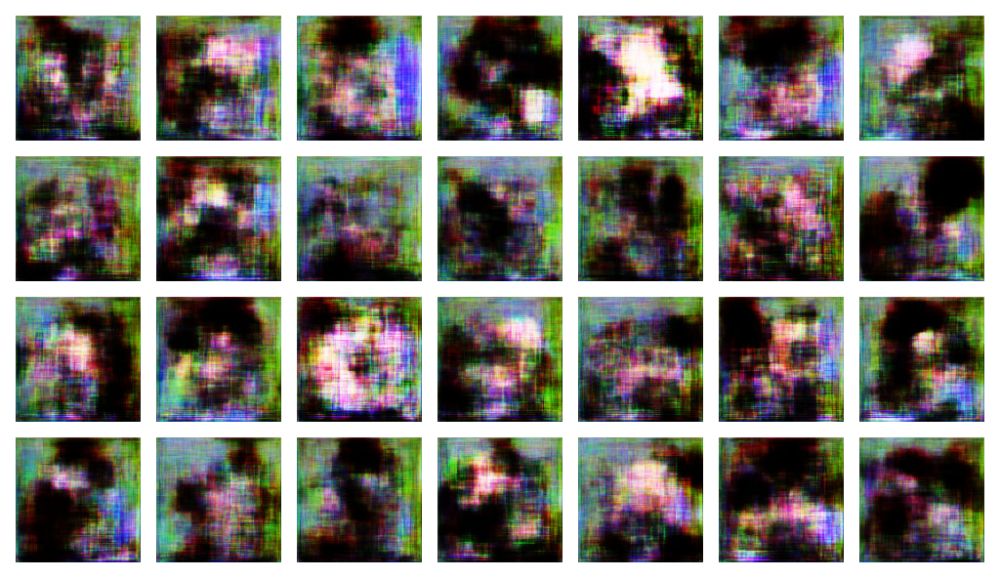

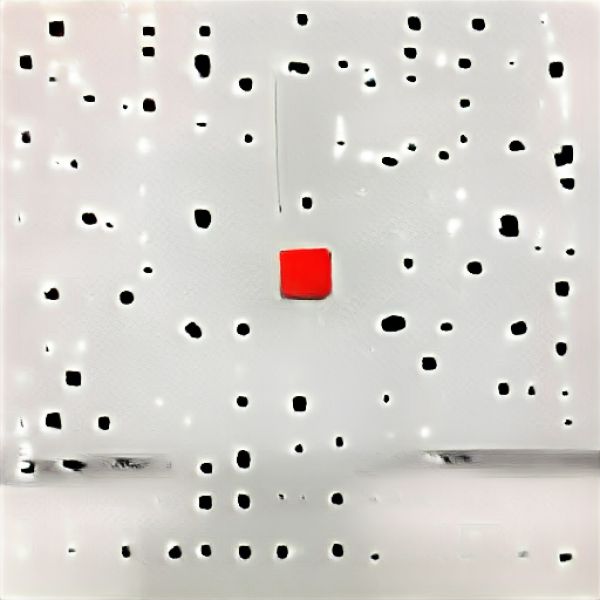

Untersuchung und Beispiele Zu Beginn steht eine zufällige Verteilung der Pixel im Bild.

GAN (Generative Adversarial Networks)

Neuronale Netze können Berechnungen zu Bildern, Texten und Wörtern erstellen, aber solange man ihnen kein Ziel vorgibt, wissen sie nicht wie sie sich weiterentwickeln sollen. Um solch eine Entwicklung zu initiieren, lässt man zwei neuronale Netze zusammenarbeiten, einerseits einen Generator, der entwickelt und andererseits einen Diskriminator, der die Entwicklung des Generators anhand von Daten aus der Vergangenheit positiv oder negativ beurteilt.

So entstehen Häufungen und Muster z.B. von Pixeln, die der Diskriminator von den Ausgangsdaten nicht mehr unterscheiden kann.

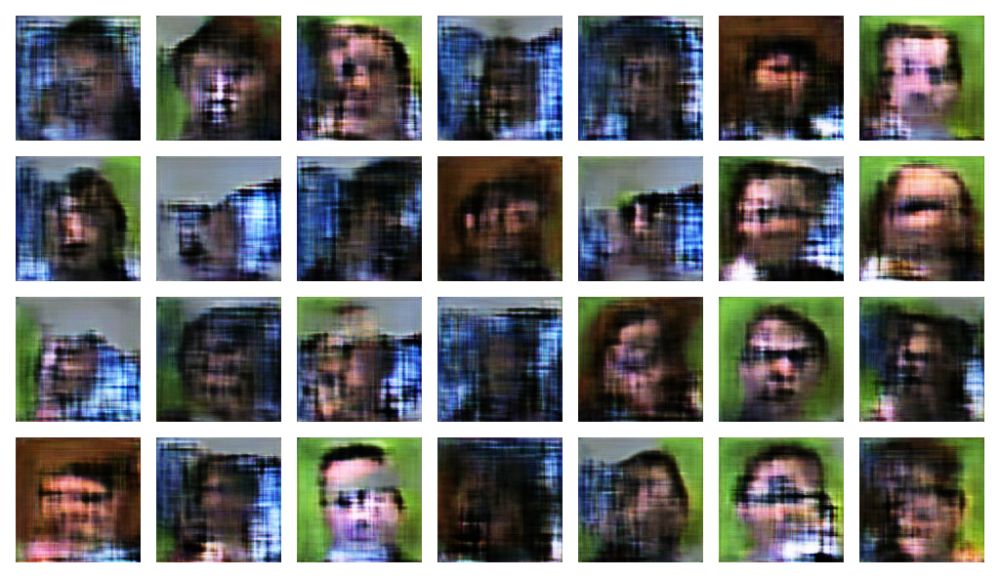

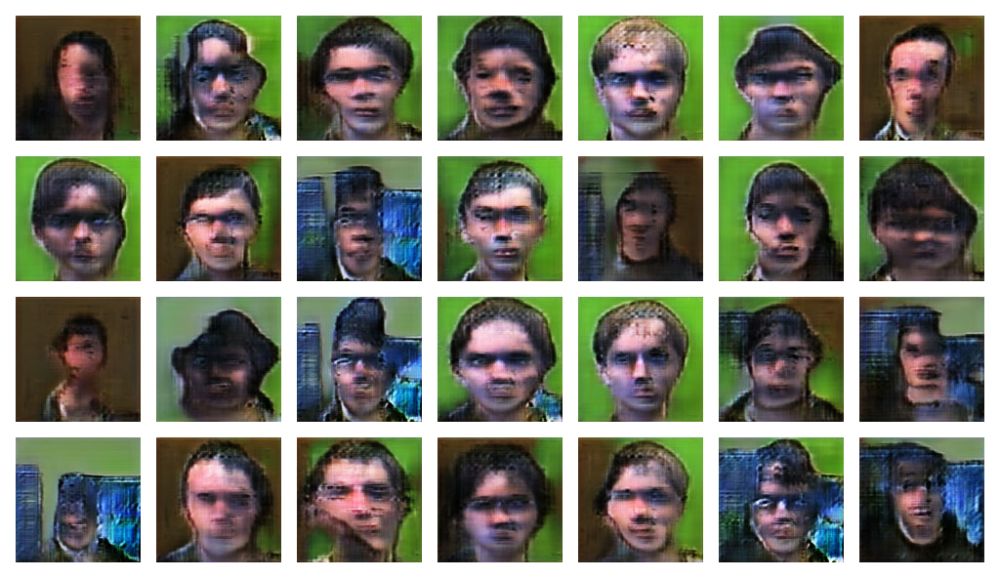

In diesem Fall handelt es sich bei den Ausgangsdaten um Gesichter.

Der hier dargestellte Zyklus umfasst mehr als 1.000.000 Iterationen.

Während die oben gezeigten Bilder auf Grafikkarten in der Cloud berechnet wurden, kann der Grafikkartenhersteller nvidia aufgrund der anderen Resourcen auch Trainingsdaten zur Verfügung stellen, mit denen folgende Bilder generiert wurden.

Overfitted

OpenAI GPT-3

Eine weitere Stufe in der digitalen Bildwerdung wurde durch die Entwicklungen von OpenAI und dem GPT3 Modell, dass sowohl der Sprach- als auch Bildgenerierung dient, erklommen.

Auch hier kommt es zum Einsatz der Transformer. Die Transformer sind in der Lage anwendungsbezogen die Gewichtung der Gewichtungen individuell zu optimieren.

Das heißt, es werden auf der Metaebene signifikante Korrekturen/Eingrenzungen bei der Selektion vorgeschaltet.

Ein bekanntes Beispiel stellen die Avocado-Sessel dar. Hier wurde das DALL·E Modell durch eine Texteingabe angewiesen, einen Sessel in Avocadoform zu entwerfen, was das Modell dann auch in vielfältigen, attraktiven Versionen vollzog.

"DALL·E is a neural network that can generate images from the wildest text and image descriptions.

CLIP uses a new method of training for image classification, meant to be more accurate, efficient, and flexible across a range of image types."

Wir nutzten für die folgenden kurzen Videos das Clip Modell (ClipBigGan, ein jupyter-notebook). Es handelt sich bei den Videos um erste, experimentelle Studien und Versuche.

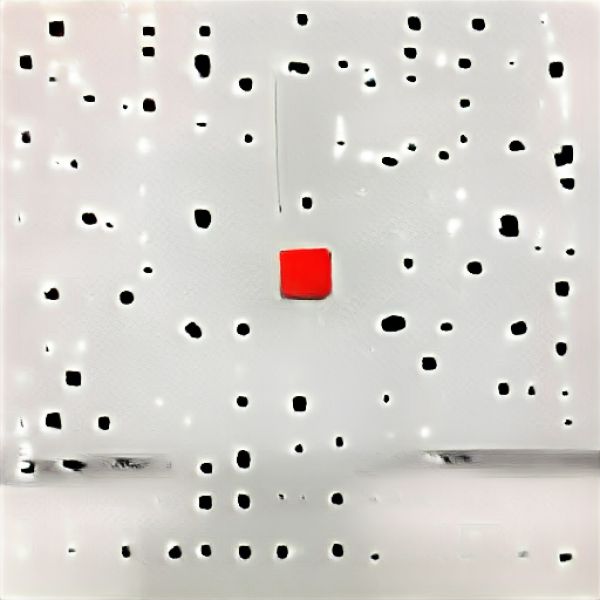

Textvorgabe: a banana attached by tape in the white cube

Textvorgabe: fine art installation in a white cube

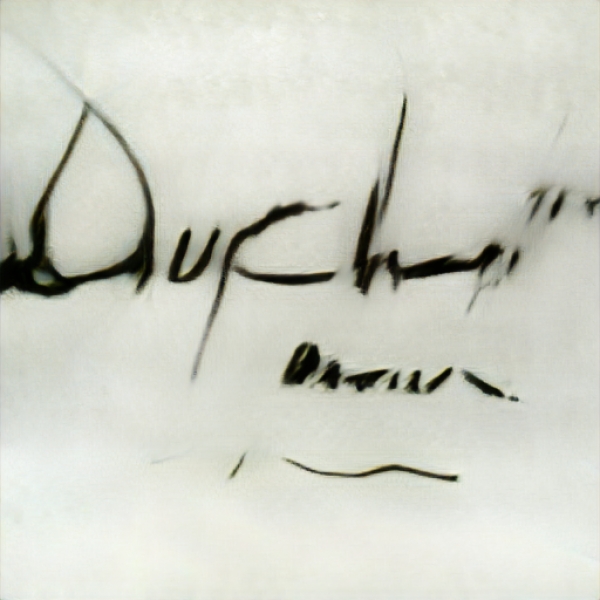

Während bei der KI gestützten Textgenerierung der Nebensatz eindeutig dem Absatz, aufgrund der Shorttherm und Longtherm Funktion, zugeordnet werden kann, verhält es sich im künstlich generierten Bildraum differenzierter. Hier entstehen scheinbare Fehlleistungen, die dem menschlichen Denken fremd erscheinen.

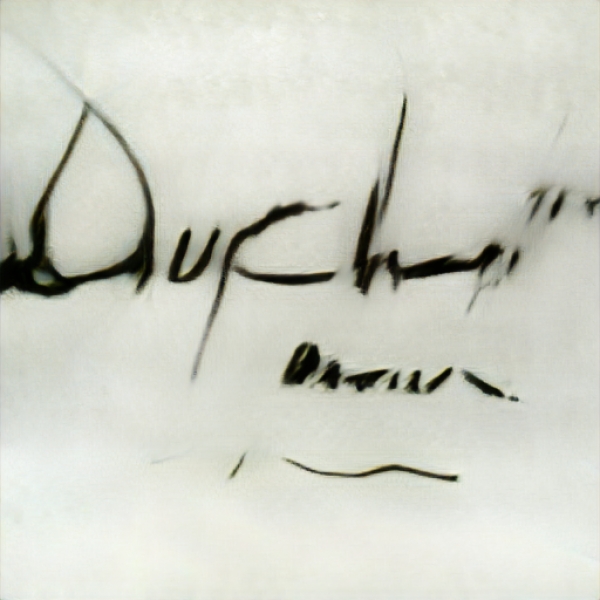

Zu sehen ist die zweite Version einer Interpretation der Signatur von Marcel Duchamp. Während bei der ersten Interpretation der VGG19 Algorithmus, der Auffälligkeiten neu assoziierte, zum Tragen kam, wird hier mit dem Gpt-3 Modell von OpenAI auf der Basis einer Texteingabe Wissen abgefragt.

Update: OpenAI DallE2

Zu Art und Umfang der im Sommer 2022 benutzten Modelle erklärt ein Sprecher vom Midjourney:

"Bei den derzeitigen Daten handelt es sich um grobe Auszüge aus dem Internet. Die Wissenschaft ist neu, aber um Ihnen eine Vorstellung zu geben, lernt das Modell aus 250 TB, merkt sich aber nur 2 GB ( das entspricht einer 125.000-fachen Reduzierung der Daten). Das heißt, es lernt hauptsächlich auf hoher Abstraktionsebene und allgemeinen Gemeinsamkeiten."

Im Dezember 2021 veröffentlichte OpenAI mit GLIDE (Guided Language to Image Diffusion for Generation and Editing) ein textgeführtes Diffusionsmodell, welches auch die Grundlage für Dall E 2 bildet.

Bei der Diffusion wird ein hochaufgelöstes Bild in Gaußsches Rauschen umgewandelt. Das Ziel des Trainings eines Diffusionsmodells besteht darin, den umgekehrten Prozess zu erlernen, d.h. aus einem Rauschen ein Bild zu erzeugen. Indem man sich entlang dieser Kette rückwärts bewegt, können so neue Daten erzeugt werden.

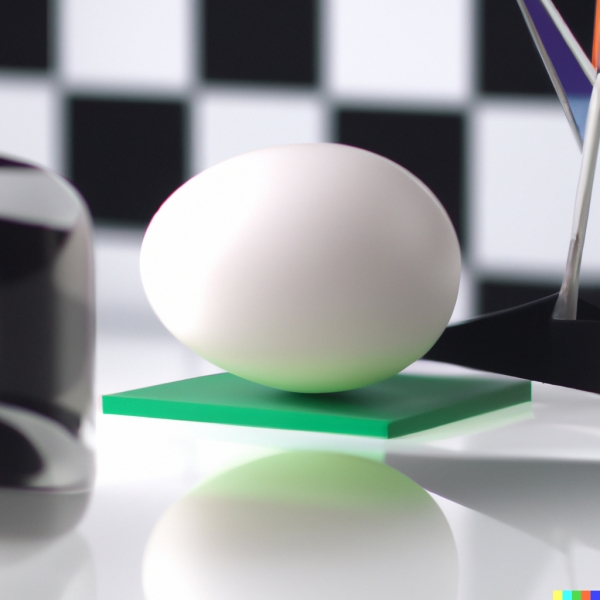

Banana attached by tape at the wall in a white cube

Banana attached by tape at the wall in a white cube

Readymade by Marcel Duchamp in a white cube

Readymade by Marcel Duchamp in a white cube

concept context identity by Marcel Duchamp in a white cube

concept context identity by Marcel Duchamp in a white cube

Readymade by Marcel Duchamp in a white cube

Readymade by Marcel Duchamp in a white cube

Modern Style Readymade by Marcel Duchamp

Modern Style Readymade by Marcel Duchamp

work of art by Marcel Duchamp in the 21st century

work of art by Marcel Duchamp in the 21st century

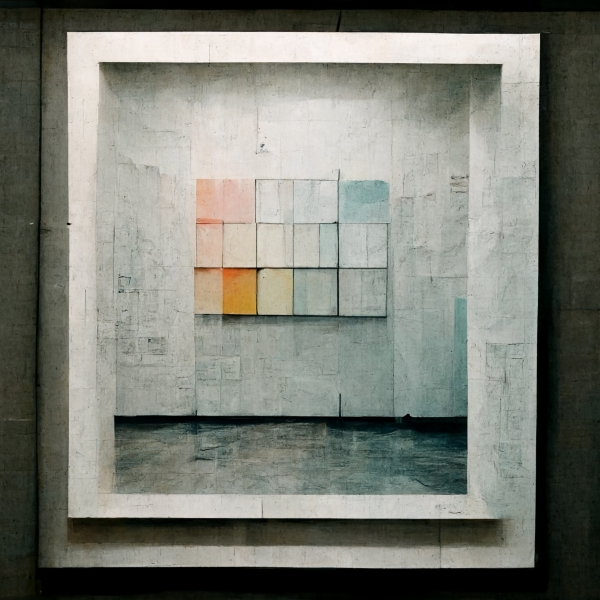

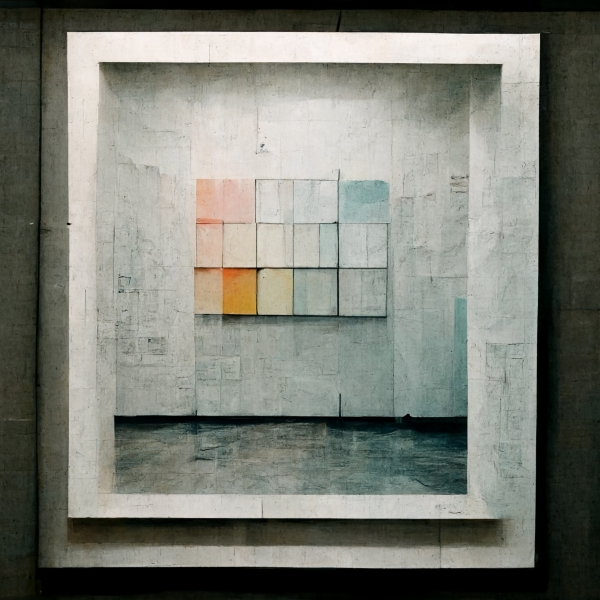

work of art in a white cube, Midjourney

work of art in a white cube, Midjourney

work of art in a white cube II, Midjourney

work of art in a white cube II, Midjourney

Anzeige

Kataloge/Medien zum Thema:

Bildgenese